Mô hình ngôn ngữ đang phát triển không ngừng, và GLaM của Google là một bước tiến quan trọng trong việc giảm chi phí tính toán khi huấn luyện các mô hình mật độ lớn. Nhưng liệu GLaM có thực sự là một giải pháp đáng chú ý cho các thách thức về tính toán và năng lượng trong lĩnh vực này?

Với 1.2 nghìn tỷ tham số, GLaM vượt xa GPT-3 về kích thước và đòi hỏi ít năng lượng hơn trong quá trình huấn luyện. Tuy nhiên, câu hỏi đặt ra là liệu kích thước lớn này có phản ánh sự tiến bộ thực sự trong hiệu suất của mô hình hay không. Dù chỉ kích hoạt một phần nhỏ tham số trong quá trình huấn luyện, GLaM vẫn tiêu tốn một lượng năng lượng đáng kể.

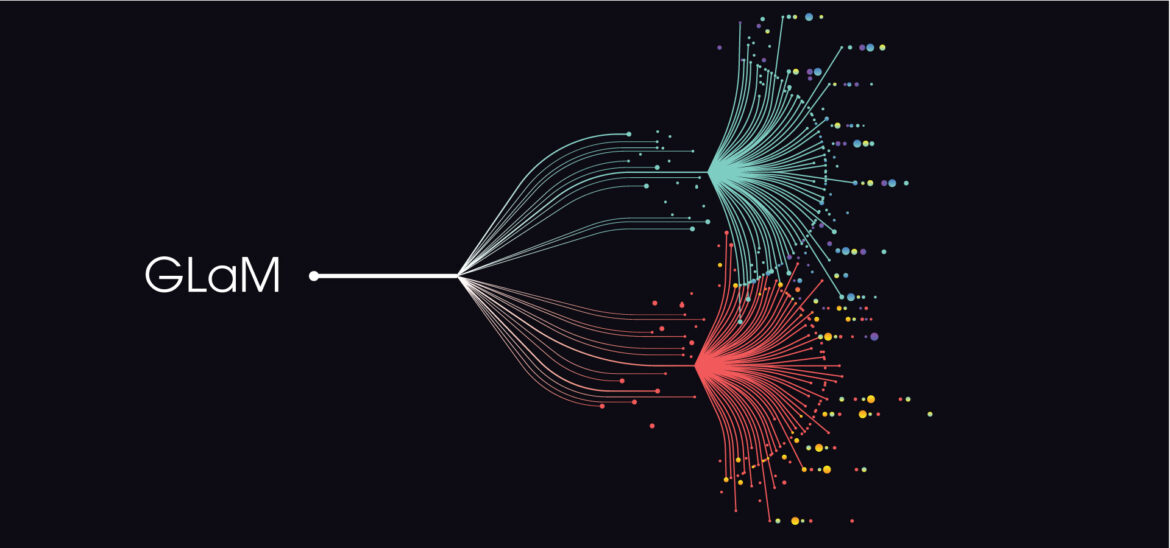

Điểm đáng chú ý khác của GLaM là sử dụng một kiến trúc sparsely activated mixture of experts, nơi chỉ một phần nhỏ các chuyên gia được kích hoạt cho mỗi token đầu vào. Điều này làm giảm chi phí tính toán, nhưng cũng đặt ra câu hỏi về sự hiệu quả của việc chọn chuyên gia trong mỗi tác vụ ngôn ngữ.

Trong khi GLaM hứa hẹn giảm chi phí tính toán và năng lượng, việc đánh giá kỹ lưỡng về hiệu suất thực sự của nó so với các mô hình khác vẫn còn là một thách thức. Cần có nhiều nghiên cứu hơn để đánh giá cả về hiệu suất và bền vững môi trường của GLaM so với các mô hình truyền thống và tiêu biểu như GPT-3.

GLaM: GLaM: Bước Tiến Hay Thách Thức Trong Nghiên Cứu Ngôn Ngữ?

Mô hình ngôn ngữ:

Hiệu suất mô hình: Hieu suat mo hinh ngon ngu va toi uu hoa moi quan he kich thuoc va du lieu

Năng lượng và tính toán: Mo hinh ngon ngu Gopher: Su tien bo va han che

Kiến trúc sparsely activated mixture of experts: Kham pha sau sac suc manh va thach thuc cua cac mo hinh ngon ngu lon

Đánh giá hiệu suất: Kham pha tiem nang va nhuoc diem cua GPT-3

Bền vững môi trường: Kham pha sau sac suc manh va thach thuc cua cac mo hinh ngon ngu lon

GPT-3: GPT-3: Mo hinh ngon ngu dot pha va ung dung tiem nang

Tác giả Hồ Đức Duy. © Sao chép luôn giữ tác quyền